Radware云端原生數據泄露事件解析 人工智能應用軟件開發的警鐘

網絡安全解決方案提供商Radware披露了一起涉及云端原生服務的數據泄露事件,該事件不僅暴露了其在基礎設施配置上的潛在脆弱性,更因其與人工智能應用軟件開發緊密關聯而引發了行業的深度反思。本文旨在解析此次事件的核心脈絡,并探討其對人工智能應用軟件開發的深遠啟示。

一、事件回顧與核心原因分析

據Radware官方通告,此次數據泄露源于其一個用于內部開發與測試的云端原生環境配置錯誤。具體而言,一個存儲著非敏感、匿名化數據的云存儲實例(如Amazon S3桶)因訪問權限設置不當(例如,被誤設為“公開可讀”),在特定時間段內暴露在公共互聯網上,可能被未經授權的第三方訪問。

核心原因可歸結為兩點:

1. 云配置管理疏忽:在敏捷開發和DevOps實踐中,快速創建和銷毀臨時云資源成為常態。此次事件凸顯了在資源生命周期管理中,尤其是權限策略的自動化實施與持續驗證方面存在疏漏。"配置漂移"或人工操作失誤未能被及時檢測和糾正。

2. 開發/測試數據管理盲區:盡管泄露的數據被描述為“非敏感”和“匿名化”,但開發與測試環境往往包含代碼片段、API密鑰占位符、系統架構信息或模擬數據。這些信息可能成為攻擊者繪制系統藍圖、發起針對性攻擊(如供應鏈攻擊)的拼圖。團隊可能降低了對該環境的安全管控標準。

二、對人工智能應用軟件開發的直接沖擊與風險放大

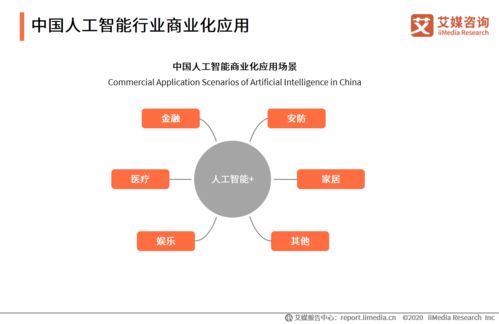

Radware作為一家提供AI驅動安全解決方案(如基于行為的Bot管理與DDoS防護)的公司,此次事件對AI應用開發領域敲響了獨特警鐘:

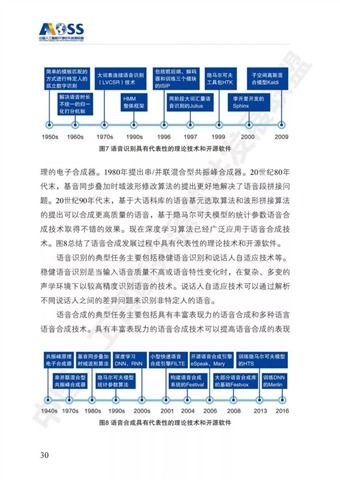

- 數據供應鏈污染風險:AI模型的訓練與迭代高度依賴數據。如果開發環境中使用的訓練數據(即使是脫敏數據)或數據預處理管道細節泄露,攻擊者可能逆向推演數據特征,實施數據投毒攻擊,從而破壞未來模型的完整性與可靠性。

- 模型資產與知識產權暴露:AI開發環境可能存有模型架構、超參數配置、未發布的算法邏輯或部分權重文件。這些是核心知識產權。泄露可能導致模型被復制、竊取或針對性地設計對抗性樣本。

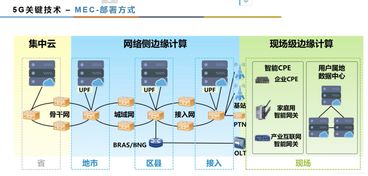

- 加劇的供應鏈攻擊面:現代AI應用開發廣泛依賴云原生服務、開源框架(如TensorFlow, PyTorch)和第三方API。云端配置錯誤暴露的元數據可能揭示整個軟件供應鏈的依賴關系,使攻擊者能夠尋找更上游的脆弱環節進行滲透。

- “影子AI”開發帶來的失控:業務部門為快速實現AI功能,可能繞過企業IT,自行使用公有云資源進行“影子AI”開發。此類非受控環境極易出現類似Radware的配置錯誤,且更難被企業安全團隊監管。

三、對AI應用開發安全實踐的啟示與建議

為避免重蹈覆轍,AI應用軟件開發團隊必須將安全左移,并貫穿整個MLOps(機器學習運營)生命周期:

- 實施“基礎設施即代碼”與策略即代碼:使用Terraform、CloudFormation等工具定義云資源,并集成Open Policy Agent等工具強制執行安全策略(如“禁止創建公開的存儲桶”)。確保所有環境(包括臨時開發環境)的創建都通過自動化、合規的模板完成。

- 強化開發測試環境的數據治理:即使對于非生產數據,也需實施分類分級。使用合成數據、差分隱私或同態加密技術處理開發測試數據。嚴格管理并輪換所有憑據與API密鑰,確保不留存真實敏感信息。

- 將安全掃描嵌入MLOps流水線:在CI/CD管道中集成云安全態勢管理、靜態應用程序安全測試和軟件組成分析工具。不僅掃描應用代碼,也要掃描基礎設施代碼、依賴包及容器鏡像,實現持續的安全合規檢查。

- 最小權限原則與零信任網絡訪問:為開發、測試環境實施嚴格的網絡隔離和最小權限訪問控制。采用零信任架構,即使在內網,訪問資源也需持續驗證身份和上下文。

- 提升全員云安全意識與專業培訓:針對AI研發人員、數據科學家進行云安全專項培訓,使其理解配置錯誤的風險。明確劃分開發、運維與安全團隊的共擔責任模型。

- 建立專門針對AI資產的威脅模型:超越傳統應用安全,識別AI模型生命周期(數據收集、訓練、部署、推理)中的獨特威脅,如對抗性攻擊、模型竊取、成員推理攻擊等,并制定相應防護措施。

四、結論

Radware的云端原生數據泄露事件,表面上是一次云配置管理失誤,實則深刻揭示了在人工智能應用軟件開發浪潮下,傳統開發安全實踐面臨的嶄新挑戰。AI項目的復雜性與對數據的極度依賴,使得開發環境本身成為了一個高價值目標。企業必須認識到,保護AI不僅在于保護生產模型,更在于守護其孕育的整個生命周期環境。唯有將安全思維深度融入從數據到模型,從代碼到基礎設施的每一個環節,構建起適應云原生與AI特性的主動防御體系,才能在享受技術創新紅利的筑牢數字時代的信任基石。

如若轉載,請注明出處:http://m.dev88.cn/product/38.html

更新時間:2026-01-08 20:50:54